AWS re:Invent 2019 참관 DAY3 <AWS DeepComposer>

3번의 Walk-up 라인 시도 끝에(*DAY1 게시글 참고) AWS DeepComposer Workshop에 참가했습니다. 이번 컨퍼런스 중 10번 이상 반복해 열릴 정도로 인기 있는 워크샵이었습니다.

AWS DeepComposer 워크샵 현장 속으로

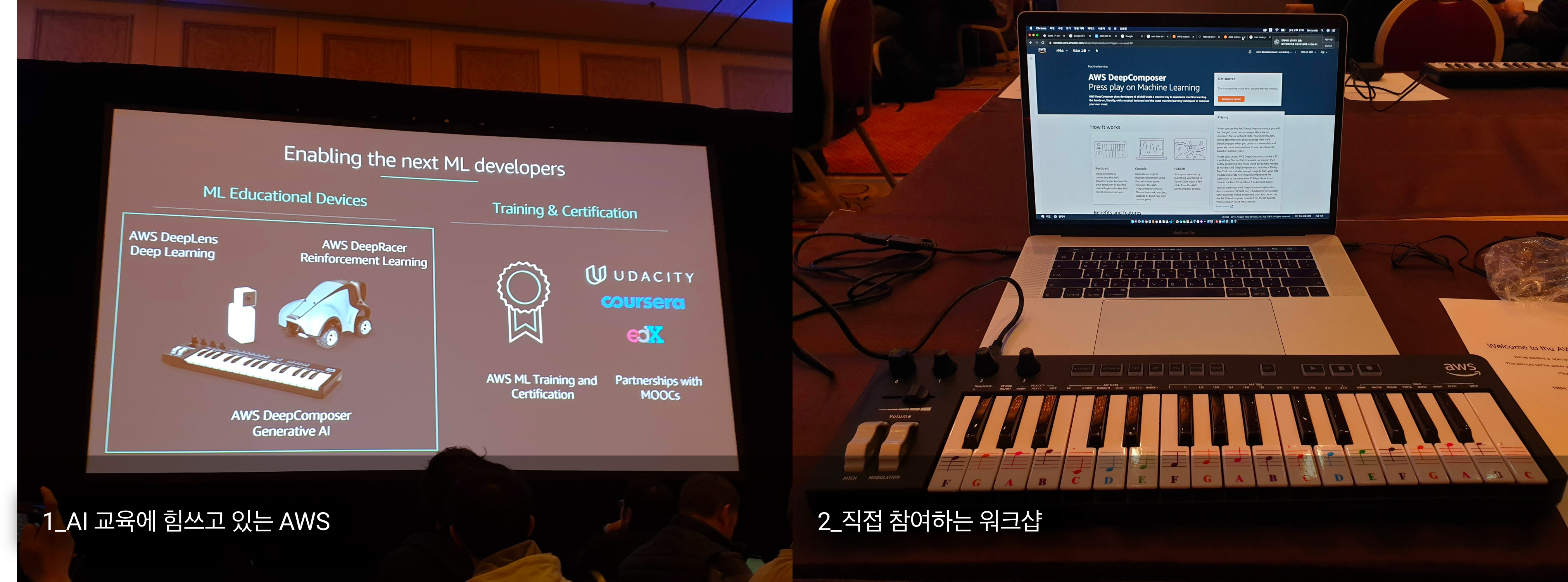

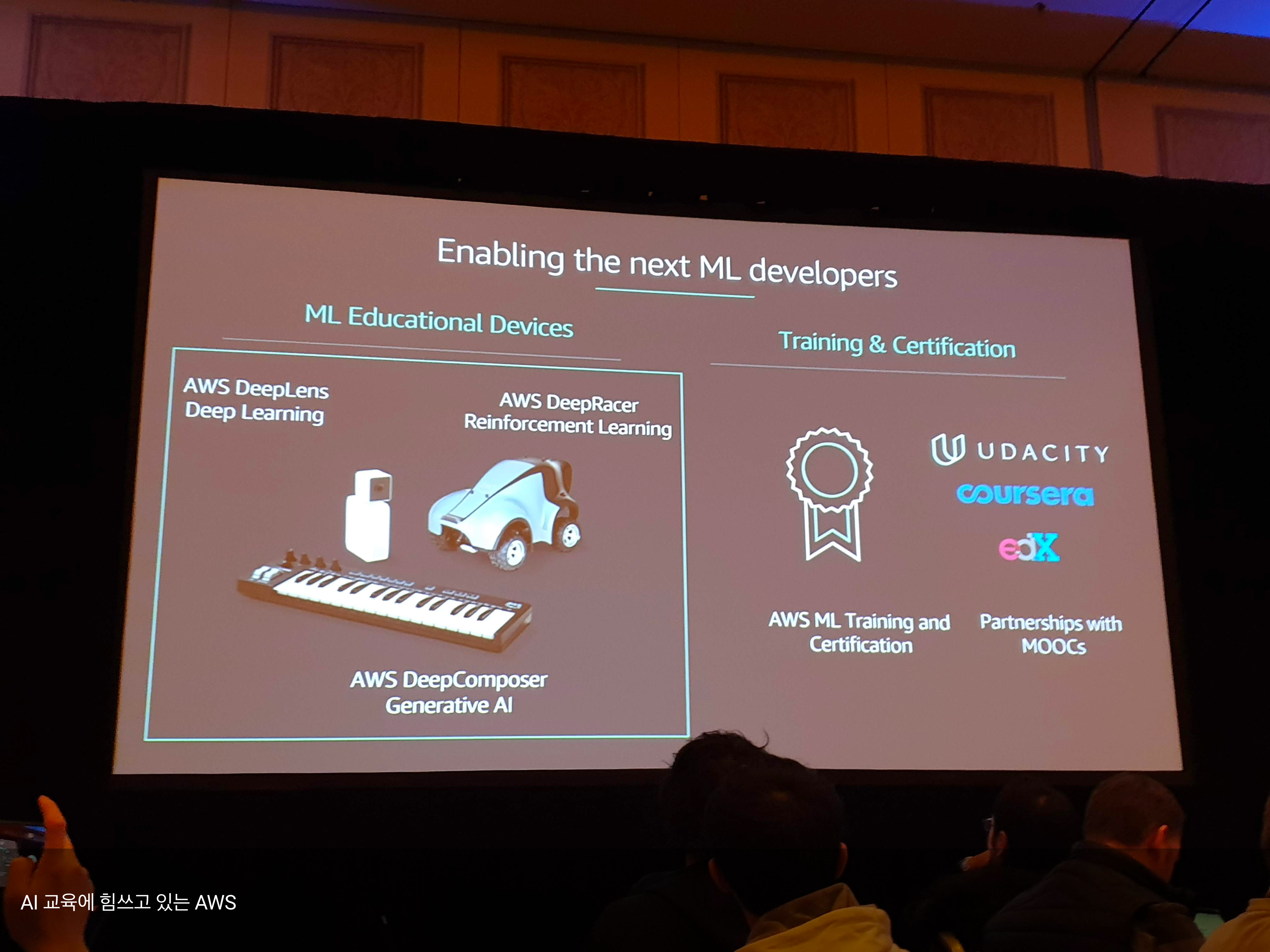

AWS에서 DeepLens, DeepRacer 이후 세 번째로 출시한 AI 교육용 제품입니다. 이런 교육용 제품으로 AI 학습 외에도 다른 MOOC들과도 많은 협업을 하고 있다고 합니다. 아마존에서 99$에 판매 중입니다.

해당 워크샵에는 노트북은 필참입니다. DeepComposer 악기를 노트북에 연결해서 수업하기 때문입니다.

다른 강의형 세션과는 다르게 참여하는 교육형 워크샵으로, 참가자들에게 직접 참여 기회를 주고 교육을 진행합니다.

- AWS 머신러닝에 대한 간단한 설명 10분

- GAN에 대한 설명 10분

- LAB1: AWS DeepComposer로 작곡해보기 35분

- LAB2: 모델 Training 해보기 55분

자세한 이야기를 하기 앞서, 위의 과정에 차근차근 참여해 DeepComposer로 제가 작곡한 노래 먼저 감상하시겠습니다. 대학생 때 밴드를 했던 실력을 살려서 Funky하게 작곡해봤는데 어떤가요?

AWS 머신러닝을 톺아보는 중

AI 서비스도 꾸준히 증가하고 있으며 SageMaker에도 많은 신제품이 출시됐으니 꼭 써보라고 합니다. 이 중 몇 가지는 렌딧에서 이미 활용 중이기도 하네요!

GAN이란 무엇일까

‘Generative Adversarial Network’의 약어인 GAN. GAN에 대한 보다 자세한 설명은 LAB2에서 주피터 노트북으로 실제 코드를 보며 진행됩니다. 왼쪽에 Generative Model에 해당하는 연주자들이 계속해서 음악을 만들어내면 지휘자로 표현되는 오른쪽의 Discriminator가 해당 음악을 평가합니다.

생성과 평가가 반복되면서 음악을 만들어내는 모델을 학습하게 됩니다.

중간중간 참가자들이 잘 이해하고 있는지를 점검하는 퀴즈도 있으니 집중력이 필요합니다.

LAB1: 작곡해봅시다

금요일 자정까지 참가자들이 자유롭게 사용할 수 있는 AWS 계정을 제공해주었습니다. 간단한 멜로디를 입력하고 작곡하기 버튼을 누르면 작곡의 결과물을 확인할 수 있습니다. 그리고 작곡가가 원하는 악기로 변경하면 결과물을 다운로드받을 수도 있구요.

LAB2: 모델 Training 해보기

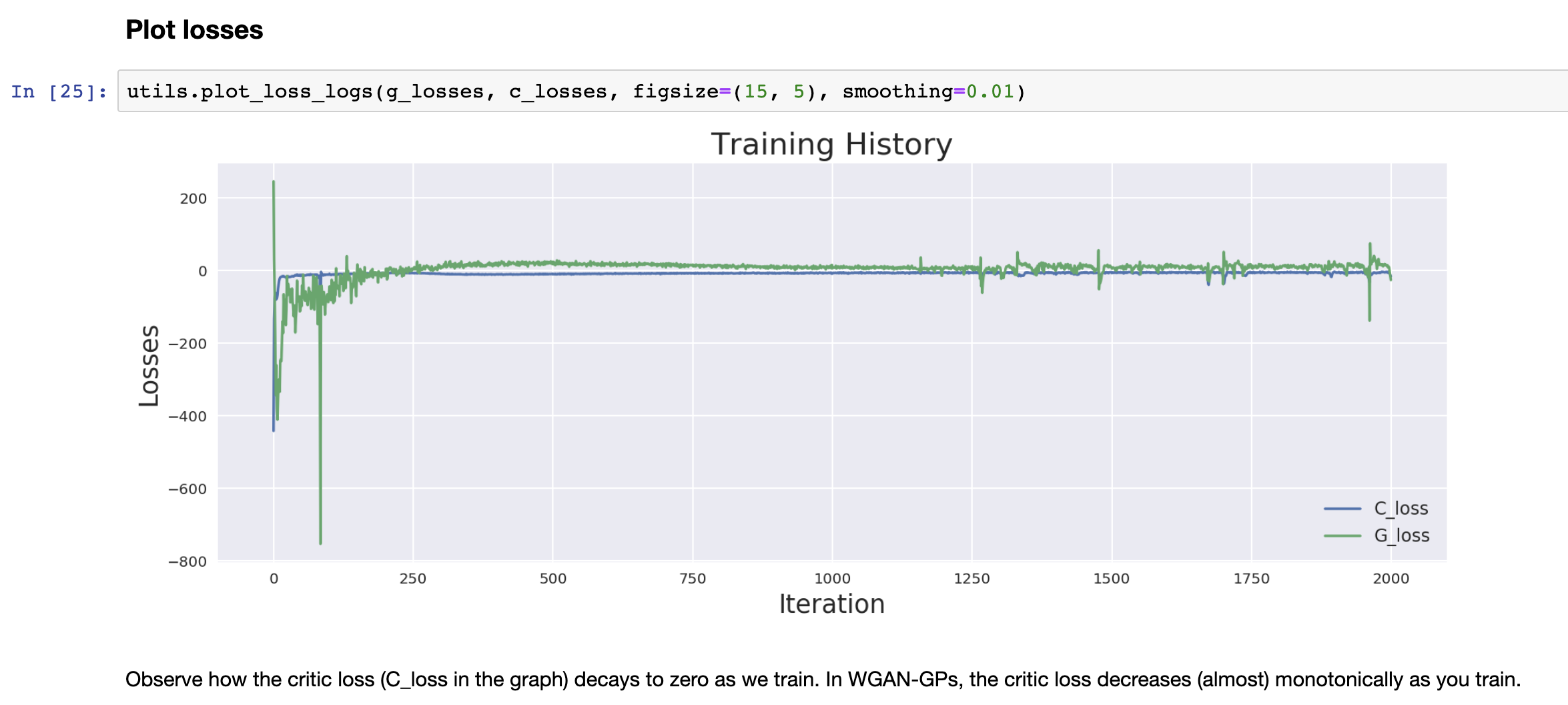

GAN 모델을 직접 트레이닝 해볼 수 있는 주피터 노트북을 제공합니다. 인스턴스도 무료라 현장에서 바로 학습이 가능합니다. 인상 깊었던 점은 2개의 Loss Function으로 구성되며 Generator Loss와 Critic Loss에 대한 자세한 설명까지 진행된 것입니다.

일러준 대로 Shift + enter 키를 눌렀더니 학습을 반복할수록 Loss Function 결과값이 0에 수렴하는 걸 확인할 수 있습니다. 학습이 진행됨에 따라 재생되는 음악이 제법 완성도를 갖춰가는 걸 확인할 수 있습니다.

이처럼 AWS re:Invent는 강의형뿐만 아니라 참여형 워크샵도 많이 열리고 있습니다.